- Выпущена экспериментальная модель DeepSeek-V3.2-Exp с новым механизмом Sparse Attention.

- Sparse Attention позволяет эффективно обрабатывать длинные тексты, снижая вычислительные затраты без заметной потери качества.

- Модель доступна в открытом доступе на Hugging Face и совместима с популярными инструментами, что способствует её широкому применению.

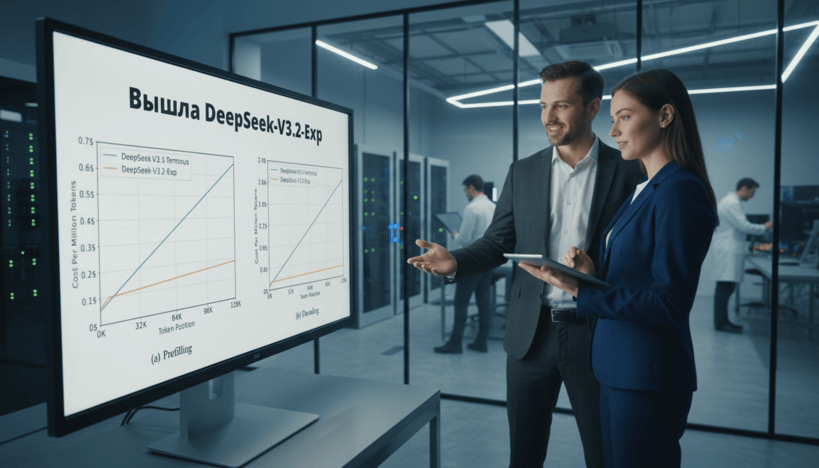

Компания DeepSeek представила новую экспериментальную модель DeepSeek-V3.2-Exp, которая, по всей видимости, является промежуточным этапом на пути к следующему масштабному обновлению их ИИ-моделей. Главным техническим новшеством стала реализация механизма Sparse Attention — особого способа оптимизации работы трансформеров, позволяющего сосредоточить вычисления только на значимых связях между словами в длинных текстах. Такая методика обеспечивает значительное сокращение вычислительных затрат и ускорение работы при практически сохранённом качестве результатов.

Сравнительные тесты модели показали, что по ряду основных бенчмарков индекс качества ответа DeepSeek-V3.2-Exp соответствует уровню предыдущей версии V3.1. Однако вычислительная эффективность возросла, что подтверждается изменениями в показателях по различным тестам: в некоторых, например, по задачам Codeforces и AIME 2025, качество даже улучшилось, тогда как в отдельных случаях, таких как Humanity’s Last Exam, наблюдается небольшое снижение. В целом это свидетельствует о том, что команда разработчиков успешно балансирует между стабильностью ответов и оптимизацией вычислений.

Open source характер модели способствует её доступности: DeepSeek-V3.2-Exp уже размещён на платформе Hugging Face и может быть интегрирован с инструментами vLLM и SGLang, для которых подготовлены соответствующие докер-образы. Это открывает широкие возможности для исследователей и разработчиков в области машинного обучения и искусственного интеллекта.

Таким образом, DeepSeek делает серьёзную ставку на удешевление и ускорение обработки длинных контекстов, что обещает расширить масштабы применения ИИ-агентов и систем Retrieval-Augmented Generation (RAG). Вероятно, в ближайшем будущем мы увидим новые крупномасштабные проекты и технологии, основанные на этой платформе.