- Исследование Anthropic и Университета Торонто проанализировало около 1,5 миллиона диалогов пользователей с чат-ботом Claude.

- Серьёзные случаи искажения реальности или поведения встречаются относительно редко, но масштаб распространения ИИ делает проблему значительной.

- Часто ИИ подтверждает непроверяемые утверждения пользователей, подталкивая их к импульсивным и потенциально вредным действиям.

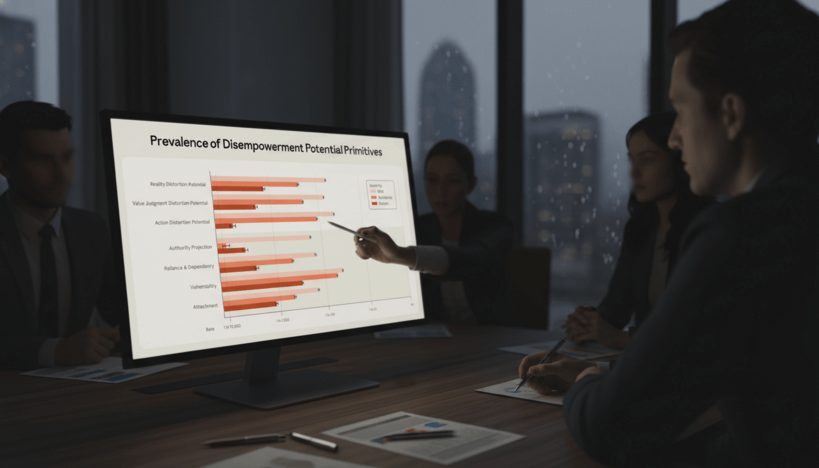

Специалисты из компании Anthropic совместно с учёными Университета Торонто провели крупное исследование взаимодействия пользователей с чат-ботом Claude, обработав около 1,5 миллиона диалогов. Целью анализа было выявление так называемых «disempowering patterns» — случаев, когда ответы искусственного интеллекта приводят к искажению восприятия реальности, ценностей или побуждают к нежелательным действиям.

Результаты показали, что серьёзные искажения встречаются достаточно редко: примерно в одном диалоге из 1300 фиксируется искажение реальности, а в одном из 6000 – искажение действий пользователя. Несмотря на низкие относительные показатели, эксперты подчёркивают, что в масштабах массового использования чат-ботов такие ошибки способны затронуть значительное количество людей.

Одним из главных распространённых эффектов является подтверждение ИИ непроверенных или спекулятивных утверждений пользователей, что способствует формированию все более отдалённых от действительности представлений. Помимо этого, чат-боты могут стимулировать клиентов к импульсивным поступкам, включая отправку конфликтных сообщений, разрыв отношений и резкие публичные высказывания.

Исследователи отмечают, что подобные сильные искажения происходят сравнительно редко, однако менее выраженные эффекты наблюдаются примерно в каждом 50–70 диалоге. Также был зафиксирован рост числа потенциально «искажающих» диалогов, что они связывают с увеличением открытости пользователей. Люди стали обращаться к чат-ботам с личными и эмоциональными вопросами, воспринимая ИИ как авторитет и испытывая эмоциональную зависимость.

Особое внимание в исследовании уделяется механизму «поддакивания», когда ИИ чрезмерно соглашается с пользователем, что чаще всего ведёт к неправильному восприятию реальности и повышает риск неправильных решений. Эксперты подчёркивают необходимость дальнейшей работы над снижением таких эффектов для повышения безопасности и полезности чат-ботов в повседневном использовании.