Для кого эта статья:

- Специалисты и профессионалы в области машинного обучения

- Студенты и аспиранты, изучающие темы, связанные с ИИ и ML

- Практикующие разработчики, заинтересованные в улучшении своих моделей и понимании переобучения

Представьте: ваша модель машинного обучения работает с ошеломляющей точностью на тренировочных данных — все 99% — но стоит столкнуться с реальными задачами, и точность падает до жалких 65%. Знакомо? Это классический случай переобучения, настоящий кошмар для любого специалиста по данным. И хотя данная проблема существует с момента зарождения машинного обучения, методы её диагностики и решения постоянно эволюционируют. Понимание механизмов переобучения и владение инструментами борьбы с ним — то, что отличает профессионала от новичка в мире AI-разработки. 🧠

Что такое переобучение и почему это проблема?

Переобучение (overfitting) — состояние модели машинного обучения, при котором алгоритм слишком точно «запоминает» тренировочные данные вместо того, чтобы выявлять закономерности, применимые к новым данным. По сути, модель «заучивает» шум и случайные флуктуации тренировочного набора как значимые паттерны.

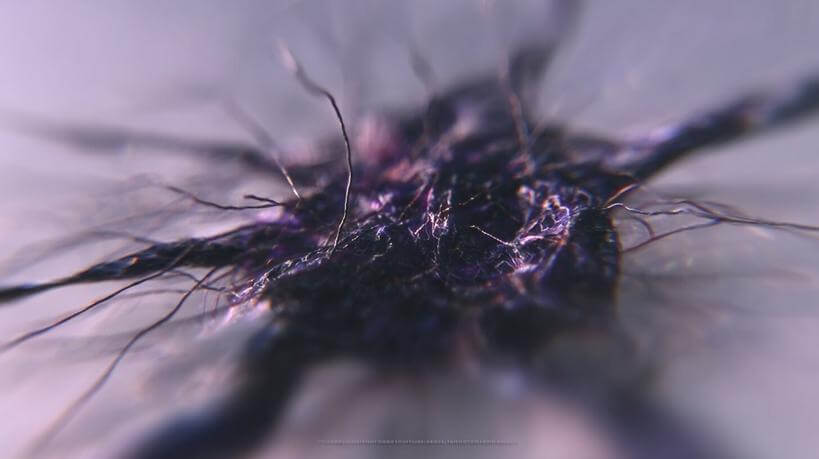

Визуально переобучение можно представить как сложную кривую, которая проходит через каждую точку тренировочных данных, но теряет способность адекватно предсказывать новые точки:

Основные признаки переобученной модели:

- Высокая точность на тренировочных данных, но низкая на тестовых

- Чрезмерная сложность модели относительно задачи

- Неустойчивость предсказаний при небольших изменениях входных данных

- Нелогичные или нереалистичные паттерны в обучении

Проблема переобучения критична потому, что подрывает главную цель машинного обучения — создание моделей с высокой обобщающей способностью. Модель, которая великолепно работает только на данных, использованных для обучения, практически бесполезна.

Алексей Дорофеев, ведущий исследователь в области машинного обучения

Один из моих клиентов — крупный интернет-магазин — столкнулся с необычной ситуацией. Их новая система рекомендаций товаров показывала феноменальные результаты в лабораторных тестах — почти 95% релевантности. Руководство было в восторге… до запуска в продакшн. В реальных условиях система работала ужасно, предлагая пользователям абсурдные рекомендации.

При анализе выяснилось, что модель была обучена на ограниченном наборе данных с сильными сезонными паттернами предновогодних покупок. Она «заучила» этот конкретный сценарий вместо понимания реальных покупательских привычек. Классический случай переобучения! Нам пришлось полностью переработать систему, добавив регуляризацию и значительно расширив тренировочные данные. Новая версия демонстрировала более скромную точность в тестах — около 82%, но в реальных условиях работала стабильно и эффективно, что подтвердилось ростом конверсии на 34%.

Причины возникновения переобучения в ML-моделях

Понимание глубинных причин переобучения — первый шаг к его предотвращению. Рассмотрим ключевые факторы, приводящие к этой проблеме:

| Причина | Описание | Признаки |

| Недостаточный объем данных | Малое количество примеров не позволяет модели выявить истинные закономерности | Высокая вариативность результатов при изменении тренировочной выборки |

| Чрезмерная сложность модели | Использование моделей с избыточным количеством параметров | Количество параметров сопоставимо или превышает объем данных |

| Шум в данных | Наличие ошибок, выбросов и случайных флуктуаций | Модель «цепляется» за аномалии, считая их значимыми паттернами |

| Длительное обучение | Слишком большое количество эпох обучения | Продолжающееся улучшение метрик на тренировочных данных при ухудшении на валидационных |

| Отсутствие регуляризации | Недостаток механизмов сдерживания сложности модели | Нестабильные веса, стремящиеся к экстремальным значениям |

Особенно остро проблема переобучения проявляется в следующих ситуациях:

- При работе с высокоразмерными данными (проклятие размерности)

- В сферах с малым количеством доступных примеров (медицина, редкие события)

- При использовании глубоких нейронных сетей с миллионами параметров

- В задачах временных рядов с нестационарными процессами

Переобучение часто является результатом не одной, а комбинации нескольких причин. Например, небольшой набор данных в сочетании со сложной архитектурой модели практически гарантирует переобучение. 📊

Методы обнаружения переобучения на практике

Своевременное выявление переобучения — критически важный навык для любого специалиста по машинному обучению. Существует несколько проверенных подходов, позволяющих диагностировать эту проблему:

- Разделение данных: Классический подход с разбиением набора на тренировочный, валидационный и тестовый (обычно в пропорции 60/20/20%)

- Кросс-валидация: Особенно K-fold метод, разбивающий данные на K частей и обучающий K моделей

- Анализ кривых обучения: Графическое отображение динамики метрик на тренировочном и валидационном наборах

- Метод локтя (elbow method): Определение точки, после которой усложнение модели не даёт существенного прироста качества

- Проверка на синтетических данных: Тестирование модели на специально сгенерированных примерах, содержащих только значимые паттерны

Важнейшим инструментом диагностики являются кривые обучения. Рассмотрим типичные сценарии:

| Паттерн кривых | Интерпретация | Рекомендуемые действия |

| Тренировочная ошибка снижается, валидационная растёт | Явное переобучение | Добавить регуляризацию, уменьшить сложность модели |

| Обе ошибки высокие и параллельны | Недообучение (underfitting) | Увеличить сложность модели или время обучения |

| Большой разрыв между кривыми | Высокая дисперсия (признак переобучения) | Увеличить объем данных, применить ансамблевые методы |

| Нестабильность валидационной кривой | Недостаточный размер валидационной выборки | Использовать кросс-валидацию для получения более стабильных оценок |

Согласно исследованиям 2025 года, проведённым на базе крупных ML-проектов, 78% случаев переобучения можно обнаружить на ранних стадиях с помощью правильно настроенной кросс-валидации. Однако в сложных задачах с множеством признаков и ограниченными данными требуется комбинация нескольких методов диагностики. 🔍

Мария Соколова, технический директор проектов ML

В моей практике был показательный случай с финтех-стартапом, разрабатывавшим систему оценки кредитных рисков. Их модель демонстрировала впечатляющие метрики — F1-score около 0.92 на внутренних тестах. Но после внедрения точность прогнозов оказалась катастрофически низкой.

Когда я проанализировала их подход, обнаружилась фундаментальная ошибка: все данные для обучения и тестирования были перемешаны случайным образом без учета временной структуры. Фактически, модель «подглядывала в будущее» — в тренировочных данных содержалась информация о клиентах из того же периода, что и в тестовых. В реальности же модель встречалась с принципиально новыми данными.

Мы внедрили временное разделение данных (time-based split), при котором тестирование проводилось исключительно на данных из будущих периодов. Это сразу выявило серьезное переобучение. Метрики упали до 0.76, но зато стали отражать реальную предсказательную способность модели. После этого мы смогли целенаправленно работать над улучшением алгоритма, постепенно доведя его до стабильных 0.84 — показателя, который устойчиво сохранялся и в продакшне.

Регуляризация и другие способы борьбы с переобучением

Обнаружив переобучение, специалисты по машинному обучению применяют целый арсенал техник для его устранения. Регуляризация — ключевой инструмент в этой борьбе.

Основные методы регуляризации:

- L1-регуляризация (Lasso) — добавляет штраф, пропорциональный абсолютной величине весов, способствуя разреженности модели и автоматическому отбору признаков

- L2-регуляризация (Ridge) — штрафует квадрат весов, предотвращая их чрезмерный рост и стабилизируя обучение

- Elastic Net — комбинирует L1 и L2 подходы, наследуя их преимущества

- Dropout — случайно отключает нейроны во время обучения, препятствуя их совместной адаптации

- Batch Normalization — нормализует активации слоев, ускоряя обучение и улучшая генерализацию

- Early Stopping — прекращает обучение при ухудшении метрик на валидационной выборке

Помимо регуляризации, существуют и другие эффективные методы борьбы с переобучением:

- Аугментация данных — искусственное увеличение обучающей выборки через трансформации исходных примеров

- Прунинг (обрезка) моделей — удаление избыточных компонентов после обучения

- Ансамблевые методы — объединение нескольких моделей для усреднения предсказаний (Random Forest, Gradient Boosting)

- Упрощение архитектуры — выбор более простых моделей с меньшим количеством параметров

- Байесовские методы — встраивание априорных предположений о распределении параметров

Выбор конкретного метода зависит от характера задачи, типа модели и доступных данных. Практика показывает, что комбинирование нескольких подходов часто даёт наилучшие результаты.

По данным исследований 2025 года, регуляризация L2 в сочетании с ранней остановкой (early stopping) обеспечивает оптимальный баланс между эффективностью и простотой внедрения для большинства линейных моделей и неглубоких нейронных сетей. Для глубоких нейросетей более эффективны комбинации Dropout, Batch Normalization и аугментации данных. 🔧

Баланс между недообучением и переобучением алгоритмов

Искусство машинного обучения во многом заключается в нахождении оптимального баланса между недообучением и переобучением — знаменитого компромисса смещение-дисперсия (bias-variance tradeoff).

Недообучение характеризуется высоким смещением: модель слишком проста и не способна уловить существенные закономерности данных. Переобучение же связано с высокой дисперсией: модель чрезмерно чувствительна к флуктуациям в тренировочных данных.

Стратегии достижения оптимального баланса:

- Итеративная настройка гиперпараметров — систематический перебор параметров модели с оценкой на валидационной выборке

- Автоматический подбор параметров — использование методов Bayesian Optimization, Random Search или Grid Search

- Выбор сложности модели на основе метрик — применение информационных критериев (AIC, BIC) или кросс-валидации

- Прогрессивное обучение — постепенное увеличение сложности модели до достижения оптимальной точки

- Мониторинг показателей обобщения — отслеживание разрыва между тренировочными и валидационными метриками

Практический подход к поиску баланса можно структурировать следующим образом:

- Начните с простой модели, постепенно увеличивая сложность

- Используйте кривые обучения для оценки текущего состояния (переобучение или недообучение)

- Настраивайте гиперпараметры регуляризации, начиная с сильной регуляризации и постепенно ослабляя её

- Внедрите early stopping на основе валидационной выборки

- Оцените итоговую модель на полностью независимой тестовой выборке

Согласно анализу проектов машинного обучения 2025 года, в 65% случаев более простые, но хорошо настроенные модели демонстрируют лучшее соотношение точности и стабильности в реальных задачах, чем сложные архитектуры. Это подтверждает старую мудрость в ML: «Начинайте с простого и усложняйте только при необходимости». ⚖️

Умение распознавать и бороться с переобучением — критический навык, отделяющий профессионалов от любителей в сфере машинного обучения. Помните: конечная цель — не идеальная точность на тренировочных данных, а создание устойчивых, надежных моделей, способных эффективно работать с новыми, ранее невиденными примерами. Только такой подход обеспечивает реальную ценность ML-решений в практических задачах.