Для кого эта статья:

- Разработчики и инженеры в области машинного обучения и искусственного интеллекта

- Исследователи, занимающиеся оптимизацией нейронных сетей и их применением на устройствах с ограниченными ресурсами

- Студенты и стажеры, изучающие современные методы машинного обучения и дистилляции знаний

Представьте, что вы пытаетесь научить робота играть в шахматы. Вместо того чтобы заставлять его учиться с нуля, вы показываете ему партии гроссмейстера — это и есть дистилляция знаний в действии. Технология, позволяющая «перелить» опыт из массивной нейросети в компактную модель, стала настоящим прорывом в оптимизации AI-систем 🧠. В 2025 году, когда вычислительные ресурсы дороги, а требования к эффективности растут, дистилляция знаний превратилась из академической концепции в критическое промышленное решение для развертывания нейронных сетей на устройствах с ограниченными ресурсами — от смартфонов до IoT-устройств.

Дистилляция знаний: сущность метода передачи опыта

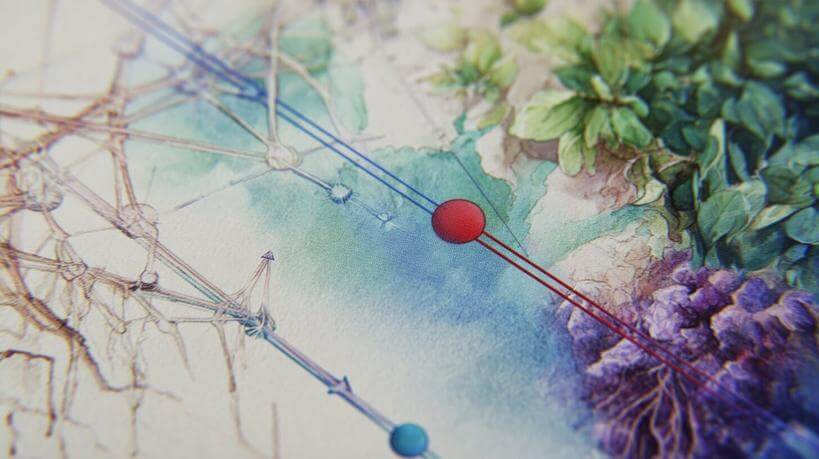

Дистилляция знаний — это процесс передачи «опыта» от сложной, избыточной модели (учителя) к более простой модели (ученику). По сути, мы создаем компактную нейросеть, которая имитирует поведение более мощной модели, но требует значительно меньше вычислительных ресурсов.

Концепция дистилляции знаний, предложенная Хинтоном и его коллегами в 2015 году, кардинально изменила подход к обучению нейронных сетей. Вместо жесткого обучения на правильных метках, модель-ученик учится воспроизводить вероятностное распределение, созданное моделью-учителем. Это позволяет захватить нюансы «рассуждений» сложной модели.

Алексей Воронцов, ведущий исследователь в области машинного обучения

Однажды мы столкнулись с непреодолимой, казалось бы, проблемой: наш разработанный алгоритм распознавания речи работал безупречно в лабораторных условиях, но был слишком требователен для внедрения в мобильное приложение. Модель занимала почти 2 ГБ и требовала значительных вычислительных мощностей. Тогда мы применили дистилляцию знаний. Взяв нашу громоздкую модель-учителя, мы разработали архитектуру ученика всего на 80 МБ. Процесс обучения занял неделю: мы передавали не только правильные ответы, но и вероятностные распределения учителя. Финальная модель-ученик сохранила 95% точности исходной, но работала в 12 раз быстрее и помещалась на любом смартфоне. Это был тот момент, когда я по-настоящему осознал мощь дистилляции — мы не просто сжали модель, мы передали ей «интуицию» учителя.

Принципиальная разница между традиционным обучением и дистилляцией заключается в использовании «мягких меток» (soft labels) вместо «жестких» (hard labels). Мягкие метки содержат информацию о степени уверенности модели-учителя в каждом возможном ответе, что делает обучение более нюансированным.

| Традиционное обучение | Дистилляция знаний |

| Использует жесткие метки (0 или 1) | Использует мягкие метки (вероятности) |

| Учит «что правильно» | Учит «как рассуждать» |

| Игнорирует информацию о сходстве классов | Передает понимание сходства классов |

| Обучение с нуля | Опирается на предварительно обученную модель |

Ключевые преимущества дистилляции знаний:

- Эффективность: Значительное уменьшение размера модели (до 10-20 раз)

- Производительность: Ускорение вывода при минимальной потере точности

- Применимость: Возможность развертывания на устройствах с ограниченными ресурсами

- Обобщение: Улучшение способности модели-ученика работать с новыми данными

Принципы работы дистилляции в нейронных моделях

Формально процесс дистилляции знаний можно описать через температурную функцию смягчения. При применении функции softmax с параметром температуры T, выходные вероятности модели становятся более или менее «размытыми» в зависимости от значения T.

Математически это выглядит так:

qi = exp(zi/T) / ∑j exp(zj/T)

где zi — логиты (необработанные выходы) модели для класса i, T — параметр температуры. При высокой температуре (T > 1) распределение вероятностей становится более сглаженным, раскрывая информацию о сходстве между классами, которая критична для обучения ученика.

Функция потерь при дистилляции обычно комбинирует два компонента:

- Потери дистилляции: расхождение между смягченными выходами учителя и ученика

- Потери на жестких метках: стандартная функция потерь между предсказаниями ученика и истинными метками

Общая функция потерь выглядит так:

L = α * Lhard + (1-α) * Lsoft

Где α — коэффициент, определяющий относительную важность каждого компонента, Lhard — стандартная функция потерь (например, кросс-энтропия с истинными метками), Lsoft — кросс-энтропия между смягченными выходами учителя и ученика.

Процесс дистилляции включает следующие шаги 🔄:

- Обучение крупной модели-учителя на целевой задаче

- Проектирование меньшей архитектуры модели-ученика

- Генерация смягченных выходов от учителя для обучающих данных

- Обучение ученика с комбинированной функцией потерь

- Тонкая настройка гиперпараметров (температуры, весового коэффициента α)

В 2025 году исследования показали, что наиболее эффективная дистилляция происходит, когда T находится в диапазоне 2-5, а α ≈ 0.7, хотя оптимальные значения могут различаться в зависимости от задачи.

Методы оптимизации нейросетей через дистилляцию

Развитие дистилляции знаний привело к появлению различных методов, каждый из которых фокусируется на определенных аспектах передачи знаний. Выбор конкретного подхода зависит от архитектуры сетей и решаемой задачи.

Мария Соколова, руководитель проектов по оптимизации ML-инфраструктуры

Когда нашей команде поручили оптимизировать систему компьютерного зрения для розничной сети из 1200 магазинов, мы столкнулись с серьезным вызовом. Оригинальная модель для отслеживания товаров на полках была построена на ResNet-152 и требовала дорогих GPU для функционирования в реальном времени. Бюджет не позволял установить такое оборудование во всех точках. Мы начали с ванильной дистилляции, но получили неудовлетворительные результаты — падение точности на 8%. Тогда мы перешли к послойной дистилляции, передавая знания не только с выхода, но и с промежуточных слоев. Настоящий прорыв произошел после применения внимания: мы буквально научили легкую модель «смотреть» на те же области изображения, что и тяжелая. Конечный результат превзошел ожидания — модель на MobileNetV3 работала в 27 раз быстрее на CPU и потеряла лишь 1.5% точности. Это позволило развернуть систему на обычных компьютерах в каждом магазине, экономя миллионы на инфраструктуре.

Современные подходы к дистилляции знаний включают:

| Метод | Основной принцип | Преимущества | Сложности |

| Ванильная дистилляция | Передача знаний через выходной слой | Простота реализации | Ограниченная эффективность для глубоких сетей |

| Послойная дистилляция (FitNets) | Соответствие активаций промежуточных слоев | Более глубокая передача знаний | Требует согласования размерности слоев |

| Дистилляция внимания | Передача карт внимания между моделями | Эффективна для задач компьютерного зрения | Сложность разработки механизмов внимания |

| Взаимная дистилляция | Модели обучают друг друга одновременно | Повышенная точность обеих моделей | Более сложная оптимизация |

| Онлайн-дистилляция | Дистилляция без предварительного обучения учителя | Экономия времени обучения | Меньшая стабильность обучения |

Критически важные аспекты для успешной оптимизации через дистилляцию включают:

- Правильный выбор архитектуры ученика: Она должна быть достаточно компактной для достижения целей оптимизации, но при этом иметь достаточную емкость для усвоения знаний учителя.

- Баланс между жесткими и мягкими метками: Чрезмерный акцент на дистилляцию может привести к тому, что модель-ученик будет копировать даже ошибки учителя.

- Аугментация данных: Расширение обучающего набора через аугментацию помогает улучшить обобщающую способность ученика.

- Планирование температуры: Динамическое изменение температуры в процессе обучения может улучшить результаты дистилляции.

Компрессия моделей: сохранение точности при меньшем размере

Дистилляция знаний стала одним из ключевых инструментов в арсенале методов компрессии нейронных сетей. Важно понимать, что она не является изолированным методом — наибольшую эффективность дистилляция демонстрирует в сочетании с другими техниками компрессии.

Сравнительная эффективность различных подходов к компрессии моделей по данным на 2025 год:

- Квантизация: Уменьшение размера на 70-80%, снижение точности на 0.5-2%

- Прореживание (Pruning): Уменьшение размера на 50-90%, снижение точности на 1-3%

- Дистилляция знаний: Уменьшение размера на 70-95%, снижение точности на 0.5-5%

- Низкоранговая факторизация: Уменьшение размера на 40-70%, снижение точности на 1-4%

Комбинируя дистилляцию с другими методами компрессии, можно добиться синергетического эффекта. Например, последовательное применение прореживания, дистилляции и квантизации позволяет сжать модели более чем в 100 раз при минимальной потере точности.

Практические рекомендации по эффективной компрессии моделей с использованием дистилляции знаний 📌:

- Начните с архитектурной оптимизации модели-ученика, используя эффективные блоки (например, MobileNet, ShuffleNet для CV или TinyBERT для NLP)

- Проведите дистилляцию с промежуточных слоев для передачи более детальной информации

- Примените прореживание к модели-ученику после дистилляции для дальнейшего уменьшения размера

- Финализируйте компрессию квантизацией весов модели до 8 или даже 4 бит

- Проведите калибровку (fine-tuning) после каждого шага компрессии на небольшой выборке данных

Для разных типов нейросетей эффективность методов компрессии варьируется:

| Тип модели | Рекомендуемые методы компрессии | Типичный коэффициент сжатия | Потеря точности |

| CNN для классификации | Дистилляция + прореживание | 10-20x | 0.5-2% |

| CNN для детекции объектов | Дистилляция с вниманием + квантизация | 5-15x | 1-3% (mAP) |

| Трансформеры для NLP | Дистилляция + прореживание головок внимания | 15-30x | 2-5% |

| RNN для временных рядов | Дистилляция + низкоранговая факторизация | 8-12x | 1-3% |

Реализация дистилляции знаний на Python: практический подход

Реализация дистилляции знаний требует четкого понимания как концептуальных основ, так и технических нюансов. Рассмотрим пример реализации дистилляции для задачи классификации изображений с использованием PyTorch.

Ключевые компоненты, необходимые для реализации:

- Предварительно обученная модель-учитель (например, ResNet-50)

- Компактная архитектура модели-ученика (например, MobileNetV2)

- Функция потерь для дистилляции, комбинирующая мягкие и жесткие метки

- Набор данных и конвейер обучения

Базовая реализация функции потерь для дистилляции знаний в PyTorch:

«`python

import torch

import torch.nn.functional as F

def distillation_loss(student_logits, teacher_logits, labels, temperature=3.0, alpha=0.5):

«»»

Рассчитывает комбинированную функцию потерь для дистилляции знаний.

Args:

student_logits: Необработанные выходы модели-ученика

teacher_logits: Необработанные выходы модели-учителя

labels: Истинные метки

temperature: Температура для смягчения вероятностей

alpha: Весовой коэффициент для балансировки жестких и мягких потерь

Returns:

Взвешенную сумму потерь дистилляции и стандартной кросс-энтропии

«»»

# Потери на жестких метках (стандартная кросс-энтропия)

hard_loss = F.cross_entropy(student_logits, labels)

# Мягкие вероятности с температурным масштабированием

soft_student = F.log_softmax(student_logits / temperature, dim=1)

soft_teacher = F.softmax(teacher_logits / temperature, dim=1)

# Потери на мягких метках (KL-дивергенция)

soft_loss = F.kl_div(soft_student, soft_teacher, reduction=’batchmean’) * (temperature ** 2)

# Взвешенная сумма потерь

return alpha * hard_loss + (1.0 — alpha) * soft_loss

«`

Схема обучения с использованием дистилляции знаний:

«`python

# Инициализация моделей

teacher_model = ResNet50(pretrained=True).eval() # Модель-учитель в режиме оценки

student_model = MobileNetV2(num_classes=1000) # Модель-ученик

# Заморозка весов учителя

for param in teacher_model.parameters():

param.requires_grad = False

# Оптимизатор для обучения ученика

optimizer = torch.optim.Adam(student_model.parameters(), lr=0.001)

# Цикл обучения

for epoch in range(num_epochs):

for images, labels in train_loader:

images, labels = images.to(device), labels.to(device)

# Получение предсказаний от обеих моделей

with torch.no_grad():

teacher_logits = teacher_model(images)

student_logits = student_model(images)

# Расчет потерь дистилляции

loss = distillation_loss(

student_logits, teacher_logits, labels,

temperature=3.0, alpha=0.5

)

# Обратное распространение и оптимизация

optimizer.zero_grad()

loss.backward()

optimizer.step()

«`

Рекомендации по эффективной реализации дистилляции знаний в производственных системах:

- Инкрементальная дистилляция: Для очень глубоких сетей эффективнее проводить дистилляцию послойно, начиная с ранних слоев.

- Настройка гиперпараметров: Проведите поиск по сетке для оптимальных значений температуры и коэффициента α.

- Аугментация данных: Используйте расширенную аугментацию для улучшения обобщающей способности ученика.

- Мониторинг и ранняя остановка: Следите за разрывом между точностью учителя и ученика и останавливайте обучение, когда разрыв перестает сокращаться.

- Проверка на разных наборах данных: Оцените производительность как на данных, схожих с обучающим набором, так и на данных из других распределений.

Расширенные техники, которые можно внедрить для улучшения результатов дистилляции:

- Дистилляция признаков: Добавьте потери для согласования промежуточных представлений между учителем и учеником.

- Внимание в дистилляции: Используйте механизмы внимания для фокусировки на наиболее информативных частях входных данных.

- Прогрессивное обучение: Постепенно увеличивайте сложность модели-ученика в процессе дистилляции.

- Дистилляция с использованием данных без меток: Включите неразмеченные данные для улучшения обобщения.

Дистилляция знаний — это больше, чем просто техническая оптимизация. Это философский подход к передаче интеллекта, позволяющий заключить мудрость крупных нейронных сетей в компактные и эффективные модели. Мастерство дистилляции знаний приходит с практикой и экспериментами. Начните с простых архитектур, постепенно усложняя подход, и вы сможете создавать модели, которые соединяют в себе точность гигантских систем с эффективностью компактных решений. Помните: истинное искусство не в создании самой большой модели, а в извлечении максимальной мощи из минимальных ресурсов.