- Компания Scale AI представила новый бенчмарк SWE-BENCH PRO для оценки ИИ в программировании.

- В SWE-BENCH PRO включены сложные задачи, требующие в среднем внесения изменений в 107 строк кода.

- Лучшие модели ИИ справляются не более чем с четвертью таких задач, показывая ограниченные возможности в реальных условиях.

Компания Scale AI представила исследование возможностей современных моделей искусственного интеллекта в решении сложных задач программирования с помощью нового бенчмарка SWE-BENCH PRO. Он создан на основе популярного теста SWE-BENCH, но усилен для проверки ИИ в условиях, максимально приближённых к реальным задачам разработки ПО.

В состав бенчмарка вошли 1865 задач, собранных из 41 репозитория, разделённых на три категории: открытый код с жёсткими лицензиями (731 задача), коммерческие закрытые проекты (276 задач) и специальный закрытый набор (858 задач) для предотвращения «подглядывания» ИИ в базу обучения. Такой подход позволяет объективно оценить, насколько модели действительно справляются с новыми, ранее не встречавшимися задачами.

Основное отличие SWE-BENCH PRO — значительный уровень сложности заданий. Средний объём требуемых правок — изменение 107 строк кода в четырёх файлах, в некоторых случаях — несколько сотен строк. Это приближает бенчмарк к реальным сценариям поддержки и развития крупных проектов, где ИИ помогает не просто понять задачу, а существенно изменять исходный код.

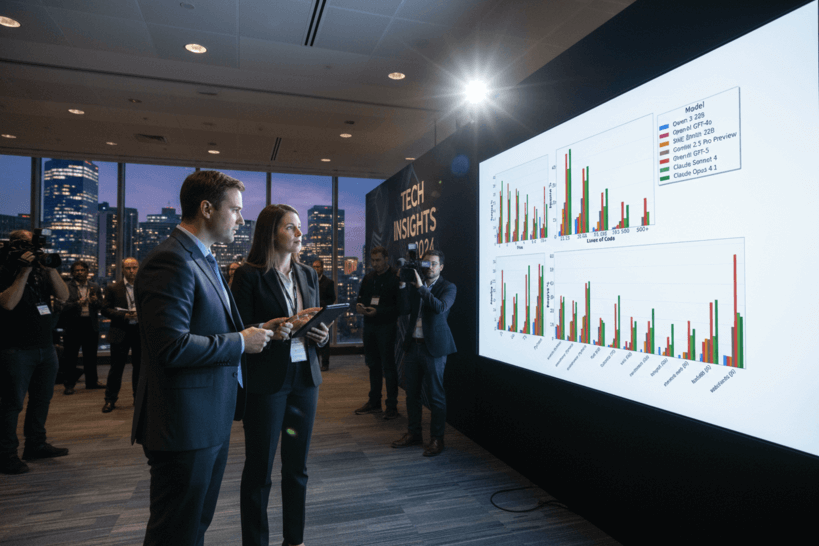

Для тестирования использовался единый агентный шаблон SWE-Agent с фиксированными настройками. Метрикой оценки стала доля задач, успешно решённых с первой попытки (Pass@1). Каждая модель могла предпринимать до 200 действий на задачу. Отчёт о результатах был сформирован по состоянию на 18 сентября 2025 года.

По результатам, опубликованным Scale AI, даже лучшие модели показывают ограниченный уровень успеха в таких реалистичных условиях. Лидирующим оказался GPT-5 с точностью решения на открытом наборе в 23,3%, следом идёт Claude Opus 4.1 — 22,7%. В коммерческих задачах наилучший результат составил 17,8%, что также принадлежит Opus 4.1. Анализ по языкам программирования выявил лучшие показатели в задачах на Python и Go, в то время как JavaScript и TypeScript оказались сложнее для моделей.

Авторы исследования подчеркивают важность SWE-BENCH PRO как более адекватного отражения реальных требований к ИИ-помощникам в программировании. Ранее обнадёживающие показатели свыше 70% успешных решений на упрощённых тестах теперь контрастируют с реальным уровнем эффективности около 18–23%. Такой разрыв демонстрирует, что современные ИИ ещё далеки от полноценной замены программистов в сложных и масштабных проектах.

Эксперты видят в SWE-BENCH PRO новую «базовую планку» для оценки прогресса в области искусственного интеллекта, которая позволит направить дальнейшие разработки в сторону создания действительно надёжных и автономных помощников для профессиональной разработки ПО.