- В Университете Северной Каролины провели имитационный судебный процесс с участием трех ИИ-чат-ботов: ChatGPT, Grok и Claude.

- Эксперимент выявил проблемы точности, предвзятости и ограничения ИИ в юридической практике, включая неспособность учитывать язык тела и человеческий опыт.

- Несмотря на критику, использование ИИ в юридической сфере растет, а разработчики видят пути совершенствования этих технологий.

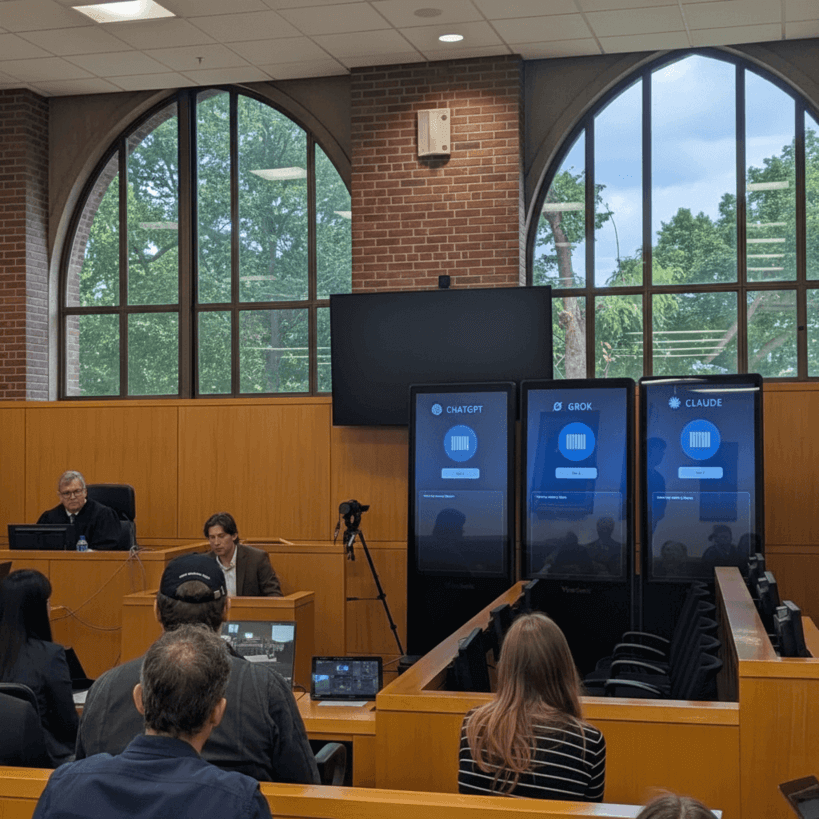

Юридическая школа Университета Северной Каролины организовала уникальный эксперимент — имитационный судебный процесс с участием ИИ-ассистентов в роли присяжных. В мероприятии приняли участие три чат-бота на базе искусственного интеллекта: ChatGPT от OpenAI, Grok от xAI и Claude от Anthropic, которые работали на отдельных экранах. Сценарий касался рассмотрения дела мужчины, обвиняемого в ограблении несовершеннолетнего. Эксперимент был разработан профессором права Джозефом Кеннеди, который одновременно выступил судьей, а его целью стало изучение ключевых вопросов точности, эффективности, легитимности и предвзятости при применении ИИ в судебных процессах.

В настоящее время тема внедрения ИИ в юриспруденцию вызывает активные дискуссии. Специалисты критикуют эти инструменты за ошибки, которые часто выражаются в подтасовке или неправильном цитировании судебных прецедентов, так называемых «галлюцинациях» моделей. Эти погрешности порождают серьезные последствия, включая штрафы и санкции против юристов, использующих технологию. Тем не менее, по данным Reuters, почти 75% юристов интегрировали ИИ в свои рабочие процессы и более половины отмечают положительный эффект от применения таких инноваций в юридической практике.

По словам профессора Эрика Мюллера, в ходе имитационного процесса чат-ботам предоставлялась расшифровка судебного заседания в режиме реального времени, после чего они совместно обсуждали материалы перед аудиторией. Однако работа ИИ-комиссии подверглась критике — эксперты отмечали, что боты неспособны анализировать невербальные сигналы, такие как язык тела свидетелей, и не обладают человеческим опытом, что существенно снижает качество их выводов. Дополнительные проблемы связаны со склонностью систем искажать информацию из-за мелких ошибок и проявлять расовую предвзятость.

Несмотря на выявленные ограничения, юридические эксперты видят потенциал для совершенствования ИИ-инструментов. По мнению Мюллера, расширение возможностей ботов за счет подключения видеотрансляций для распознавания невербальных сигналов и обеспечение более широким контекстом для анализа судебного дела позволит повысить качество и надежность их работы в будущем. Таким образом, эксперимент в Университете Северной Каролины служит важной вехой в процессе интеграции искусственного интеллекта в правовую систему.