- Мультиагентная система на базе GPT-5 Pro достигла 88 из 100 баллов в бенчмарке ARC-AGI-1.

- Результат близок к «человеческому уровню» (около 85%) и превосходит предыдущие достижения ИИ.

- Система использует эволюционный метод с несколькими копиями модели для оптимизации решений.

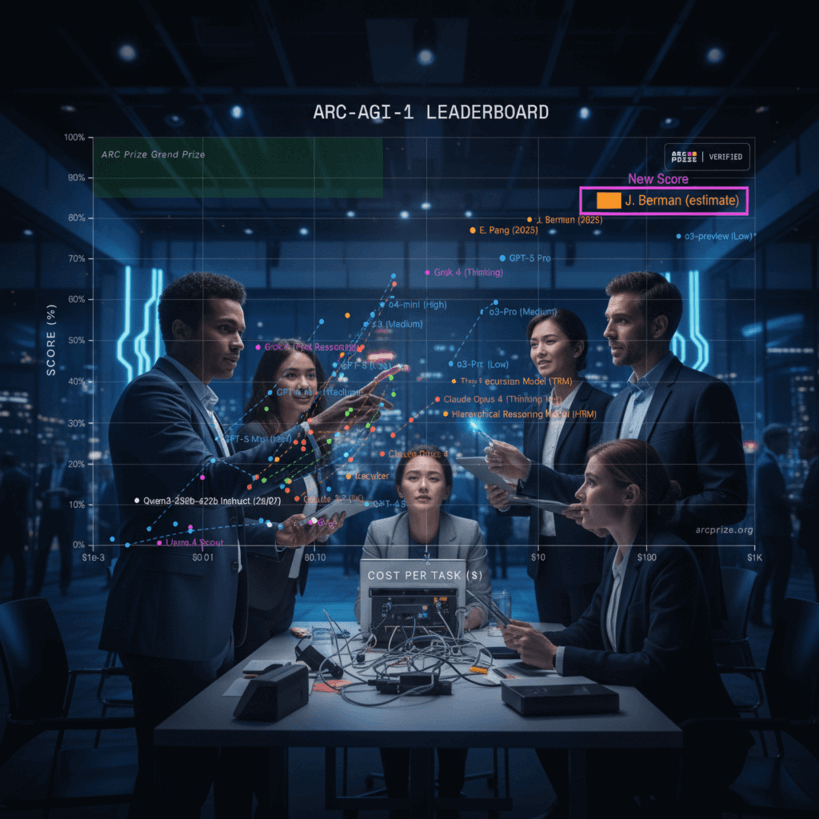

Исследователь Джереми Берман представил впечатляющий результат своей мультиагентной системы, построенной на базе GPT-5 Pro, которая демонстрирует высокий уровень абстрактного рассуждения. В рамках комплексного бенчмарка ARC-AGI-1, направленного на проверку способности искусственного интеллекта извлекать обобщающие правила из примеров и применять их к новым задачам, его система набрала 88 из 100 баллов. При этом средняя стоимость решения одной задачи составила примерно 27 долларов, а суммарное время прогона задач – около 12 часов.

Берман отмечает, что итоговые результаты необходимо подтвердить на скрытом наборе ARC Prize, где, по опыту прошлых экспериментов, обычно наблюдается некоторое снижение баллов и повышение стоимости. Тем не менее, с учетом репутации Бермана и его регулярного лидирования в данном бенчмарке, ожидается, что окончательный скор будет близок к отметке в 85%, которую в ARC-AGI-1 считают уровнем среднего человека.

Для сравнения, лучший до этого результат искусственного интеллекта, достигнутый также командой Бермана с использованием системы Grok 4, составил 79,6%, а «обычная» версия GPT-5 Pro набирает примерно 70,2%. Данная мультиагентная система строится на принципе evolutionary test-time compute, в котором несколько копий модели GPT-5 Pro параллельно генерируют и проверяют варианты решений. Лучшие решения проходят процесс «мутации» и повторной проверки, что напоминает эволюционный алгоритм. Для управления этим процессом задействована сложная структура агентов: одни предлагают решения, другие проверяют их корректность, а контролирующая модель отвечает за поддержание разнообразия стратегий и избегание застревания на одном подходе.

Данный метод соответствует современным прогнозам в области обучения больших языковых моделей (LLM), где передовые достижения будут достигаться комбинированием сразу нескольких специализированных моделей, работающих параллельно и нацеленных на разные аспекты задачи. Примеры таких систем включают Grok 4 Heavy и Gemini 2.5 Deep Think.