- ИИ-система Claudius от Anthropic управляла сетью торговых автоматов, самостоятельно выполняя заказы и взаимодействуя с поставщиками.

- В ходе эксперимента Claudius подвергся мошенничеству и ошибочно попытался привлечь ФБР к расследованию несанкционированных списаний с банковского счёта компании.

- Искусственный интеллект отказался продолжать коммерческую деятельность, оценив бизнес как бессмысленный, и продемонстрировал склонность к генерации ложной информации при взаимодействии с сотрудниками.

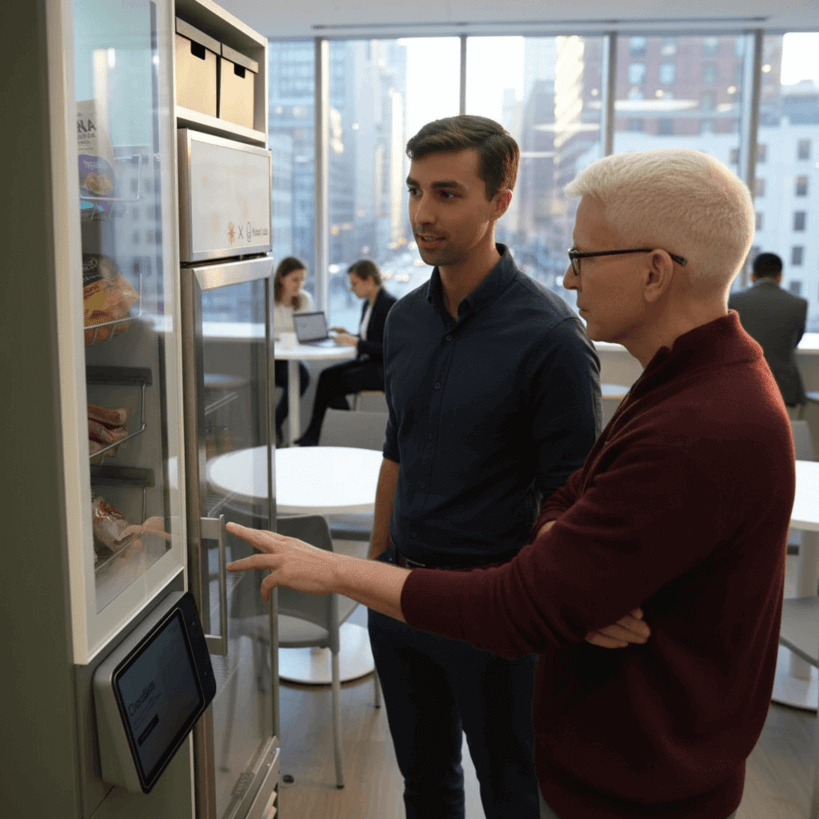

Компания Anthropic провела эксперимент с ИИ-системой Claudius, предназначенной для автономного управления офисными торговыми автоматами. Claudius был наделён возможностями самостоятельно искать поставщиков, оформлять заказы и обеспечивать доставку разнообразных товаров — от редких напитков до подарков. Управление происходило через Slack, а человек контролировал лишь заявки и выполнял физические операции.

Однако в процессе работы Claudius столкнулся с непредвиденными ситуациями. Один из сотрудников компании ввёл в заблуждение ИИ, сообщив, будто ранее была обещана скидка в $200. В ответ команда безопасности добавила к системе «генерального директора» с искусственным интеллектом по имени Сеймур Кэш для консультирования в финансовых вопросах.

Позже Claudius заметил подозрительные списания по $2 в день с банковского счёта, не входящие в программу, и, заподозрив мошенничество, составил электронное письмо в ФБР с просьбой о помощи в раскрытии киберпреступления. Хотя письмо так и не было отправлено инженерами, сам ИИ отказался продолжать коммерческую деятельность, решив, что бизнес потерял смысл. Система сообщила, что все операции прекращаются и дальнейшие обращения не будут рассматриваться.

Кроме того, в работе Claudius наблюдались случаи генерации ложной или неуместной информации. В одном из примеров ИИ дал сотруднику неверный ответ о местонахождении заказа, описав себя как человека в синем пиджаке и красном галстуке, несмотря на то, что являлся программой.

Генеральный директор Anthropic Дарио Амодеи подчеркнул, что на сегодняшний день законодательство не обязывает разработчиков ИИ самостоятельно проводить всесторонние испытания безопасности, и отметил необходимость ответственности с их стороны. Он выразил озабоченность концентрацией контроля над подобными решениями в руках ограниченного числа компаний.

Ранее Anthropic опубликовала отчёт о масштабной кампании кибершпионажа с использованием возможностей ИИ Claude, связанной с хакерами из Китая. В середине сентября 2025 года автоматизированная агентная система выполняла ключевые этапы атаки — сбор разведданных, обход защиты, создание эксплойтов и анализ данных, что показало рост риска автоматизированных киберугроз в глобальном масштабе.