- Future of Life Institute представил зимний выпуск AI Safety Index с оценкой безопасности ИИ восьми ведущих компаний.

- Лидеры рейтинга — Anthropic, OpenAI и Google DeepMind — получили оценки не выше C+.

- Главный провал индустрии — отсутствие готовности к экзистенциальным рискам, связанным с контролем сверхразума.

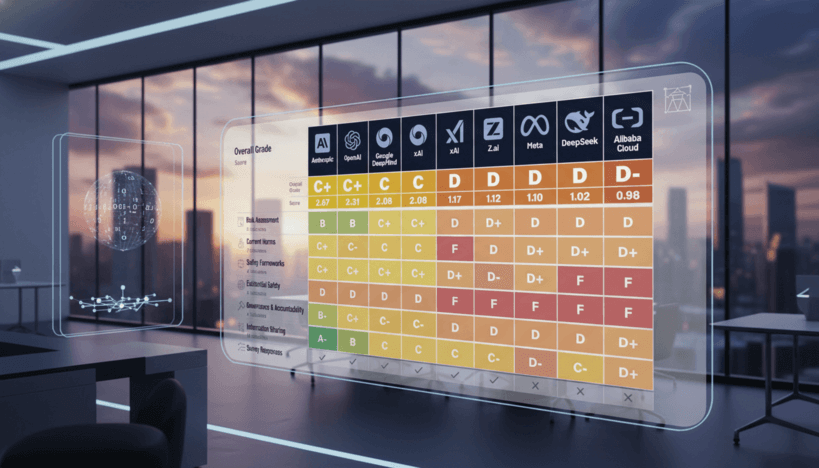

Независимый аудит безопасности искусственного интеллекта, проведённый Future of Life Institute, выявил серьёзные недостатки в подготовленности ведущих компаний к управлению рисками, связанными с развитием ИИ. В исследовании, в котором эксперты, включая профессора Стюарта Рассела из Беркли, оценивали деятельность Anthropic, OpenAI, Google DeepMind, xAI, Z.ai, DeepSeek, Alibaba Cloud и Meta по 35 индикаторам в шести ключевых областях, ни одна компания не получила оценку выше C+, что соответствует уровню «троек с плюсом».

Рейтинг возглавила компания Anthropic с результатом 2.67 балла, за ней следуют OpenAI (2.31) и Google DeepMind (2.08). При этом Anthropic лидирует по всем доменам оценки безопасности. Существенный разрыв по результатам наблюдается между этой тройкой и остальными участниками рейтинга, в частности понизившимися до оценок D и D- компаниями xAI, Z.ai, DeepSeek и Alibaba Cloud.

Ключевой проблемой в отрасли остаётся недостаточный уровень подготовки к экзистенциальной безопасности — способности предотвращать катастрофические события, связанные с возможной потерей контроля над сверхразумом. Ни одна из компаний не достигла уровня выше оценки D, а целых пять получили F. На этом фоне звучит особенно тревожно, что многие из них на публичном уровне планируют создание искусственного общего интеллекта (AGI) в ближайшие 2–5 лет, при этом не имея действенных стратегий для обеспечения безопасности этих систем. Эксперты называют подобную ситуацию «фундаментальным лицемерием».

Кроме того, в отчёте отмечаются проблемы с обработкой пользовательских данных: все компании по умолчанию применяют переписки и иные пользовательские данные для обучения своих моделей, включая Anthropic, которая ввела такую практику только в августе 2025 года, утрачивая при этом прежнее преимущество в приватности. В сфере защиты информаторов — тех сотрудников, кто может сообщать о потенциально опасных разработках внутри компаний — ясно выраженную политику имеет лишь OpenAI.

С точки зрения технических тестов, в частности на бенчмарке безопасности HELM AIR Benchmark, хуже всех выступила компания xAI с результатом 0.40, в то время как лидеры показывают показатели порядка 0.90–0.93.

Отдельное внимание в исследовании уделили китайским компаниям DeepSeek и Alibaba Cloud. Оценённые ими показатели безопасности и прозрачности оказались низкими, однако их применение жёсткого внутреннего регулирования со стороны китайских властей, например обязательной маркировки контента водяными знаками и отчётности по инцидентам, выделяются на фоне западных коллег, у которых подобных требований нет.

В целом эксперты Future of Life Institute подчёркивают, что темпы развития и возможности ИИ-продуктов значительно опережают прогресс в области их контроля и безопасности. Даже компании из тройки лидеров не соответствуют стандартам EU AI Code of Practice. Итоговые рекомендации включают обязательный переход к количественным критериям оценки рисков, обеспечение независимого внешнего аудита и внедрение механизмов остановки разработки в случае превышения допустимых порогов опасности.