- Каждый седьмой запрос в библиотеку штата Вирджиния содержит ссылки на несуществующие источники, сгенерированные искусственным интеллектом.

- Международный комитет Красного Креста фиксирует массовые обращения за вымышленными документами, созданными языковыми моделями ИИ.

- Разработчики ИИ внедряют новые методы для сокращения количества так называемых «галлюцинаций» в ответах моделей, включая механизм отчётности в GPT-5.

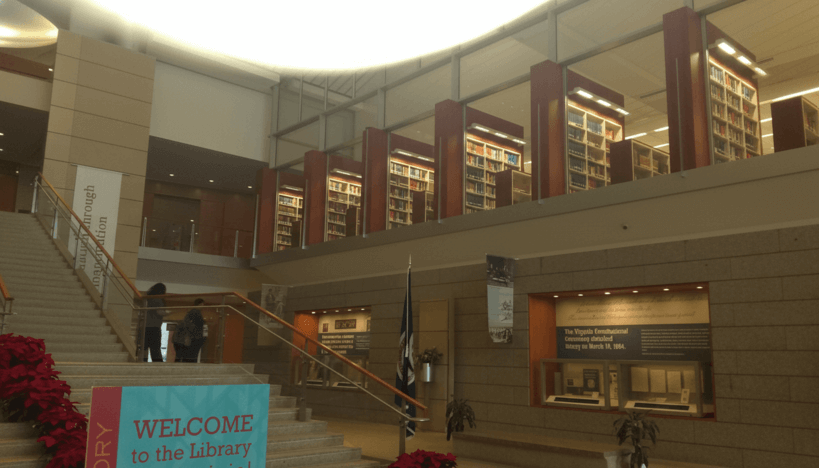

В США библиотеки и крупные архивы начали сталкиваться с серьёзной проблемой, связанной с использованием искусственного интеллекта при поиске научных источников. По данным библиотеки штата Вирджиния, около 15% электронных запросов содержат ссылки на документы, журнал или книги, которые не существуют — эти данные сгенерированы такими ИИ-моделями, как ChatGPT. Тенденция возросла после выхода модели GPT-3.5 в конце 2022 года.

Сара Фоллз, возглавляющая отдел обслуживания исследователей в Library of Virginia, отмечает, что для сотрудников библиотеки становится всё сложнее доказать отсутствие конкретного документа. В связи с этим институт планирует ввести требования для пользователей: проверять достоверность источников перед обращением и указывать, были ли ссылки получены с помощью ИИ. Также предполагается ограничить время, которое специалисты тратят на проверку и верификацию поступающих запросов.

Аналогичную проблему зафиксировал Международный комитет Красного Креста (МККК), один из крупнейших гуманитарных архивов мира. Ведомство предупреждает о массовом появлении вымышленных каталогов и документов, как, например, несуществующий Journal of International Relief и International Humanitarian Digital Repository, которые создают языковые модели. Это связано с тем, что современные ИИ не производят реальный поиск по базам и не умеют отказываться от ответа, подавая информацию на основе статистических шаблонов, что порождает ошибочные или фиктивные данные.

В то же время разработчики искусственного интеллекта предпринимают шаги для минимизации подобных «галлюцинаций». Так, при обучении GPT-5 использовалась отдельная система, которая выявляет ошибочные ответы и отправляет их для доработки. Кроме того, в данной версии модели реализован исследовательский режим «Confessions», позволяющий ИИ подробно объяснить причины и уровень уверенности по каждому ответу. Эта функция призвана помочь инженерам OpenAI улучшать качество моделей и снижать количество выдаваемых неверных данных.