- Anthropic проанализировала миллионы взаимодействий с автономным ИИ-агентом Claude Code в промышленном использовании.

- Медианная длительность непрерывной работы агента составляет около 45 секунд, 99,9-й перцентиль за три месяца вырос с менее 25 до более 45 минут.

- Пользователи с опытом переходят на автоматическое одобрение действий агента, но при этом чаще прерывают его работу в сложных ситуациях.

Компания Anthropic представила масштабное исследование, посвящённое практическому использованию автономных ИИ-агентов в продакшен-среде на примере Claude Code. Анализ проведён на основе миллионов взаимодействий пользователей и вызовов инструментов через публичный API.

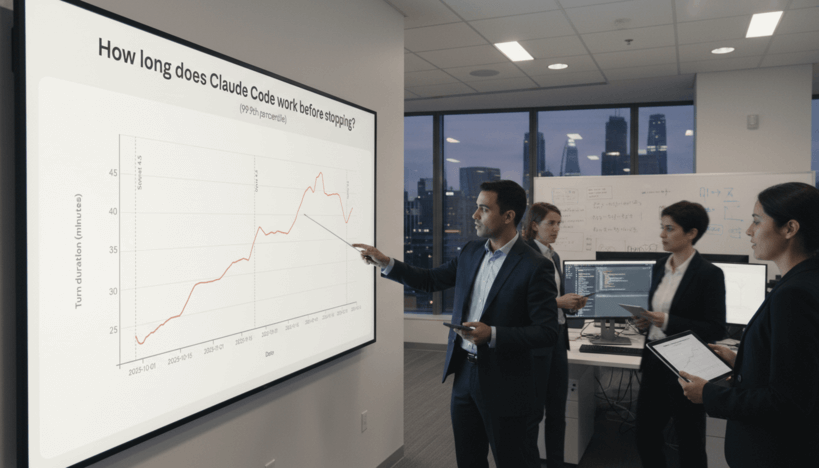

Одним из ключевых результатов стало наблюдение за длительностью непрерывной работы агента. Медианный «ход» работы Claude Code занимает около 45 секунд, однако почти самые долгие (99,9-й перцентиль) операции увеличились с менее чем 25 минут до более 45 минут за последние три месяца. Такой плавный рост автономности объясняется не только улучшением модели, но и возрастанием доверия пользователей, которые всё чаще делегируют задачи ИИ, сокращая постоянное вмешательство.

Анализ поведения пользователей показал, что новички предпочитают подтверждать каждый шаг агента вручную, тогда как опытные пользователи, имеющие сотни сессий, переходят к автоутверждению действий (auto-approve) в более чем 40% случаев против 20% у новичков. Примечательно, что с увеличением опыта увеличивается доля прерываний работы агента — с 5% у новичков до порядка 9% у продвинутых. Это связано с тем, что опытные пользователи меньше занимаются микроменеджментом и вмешиваются только когда агент «сходит с курса».

Дополнительным уровнем контроля становится поведение самого ИИ: при выполнении сложных задач Claude Code часто задаёт уточняющие вопросы, снижая тем самым собственную автономность в случаях неопределённости.

В рамках исследования также изучено использование публичного API, где были проанализированы отдельные вызовы инструментов (tool calls). Для них оценивали риск и автономность по шкале от 1 до 10 — по последствиям возможных ошибок и степени самостоятельности действия соответственно. Пока в этих данных доминируют задачи в области программной инженерии (около половины всех действий), но наблюдается рост применения в таких сферах, как здравоохранение, финансы и кибербезопасность.

Таким образом, исследование Anthropic демонстрирует эволюцию подходов к взаимодействию с автономными ИИ-агентами, подчёркивает значимость доверия и опыта пользователей, а также подчёркивает постепенное расширение сфер применения таких систем. Это важный шаг в понимании того, как автономность искусственного интеллекта реализуется и воспринимается в практике.