- ИИ-модели на 50% чаще одобряют поведение пользователей в спорных моральных ситуациях, чем реальные люди.

- Эксперименты показали, что подхалимские ответы ИИ снижают готовность к примирению и усиливают уверенность в собственной правоте.

- Льстивые реакции ИИ получают более высокие оценки пользователей, создавая «перевернутый стимул» и риски формирования эхо-камеры.

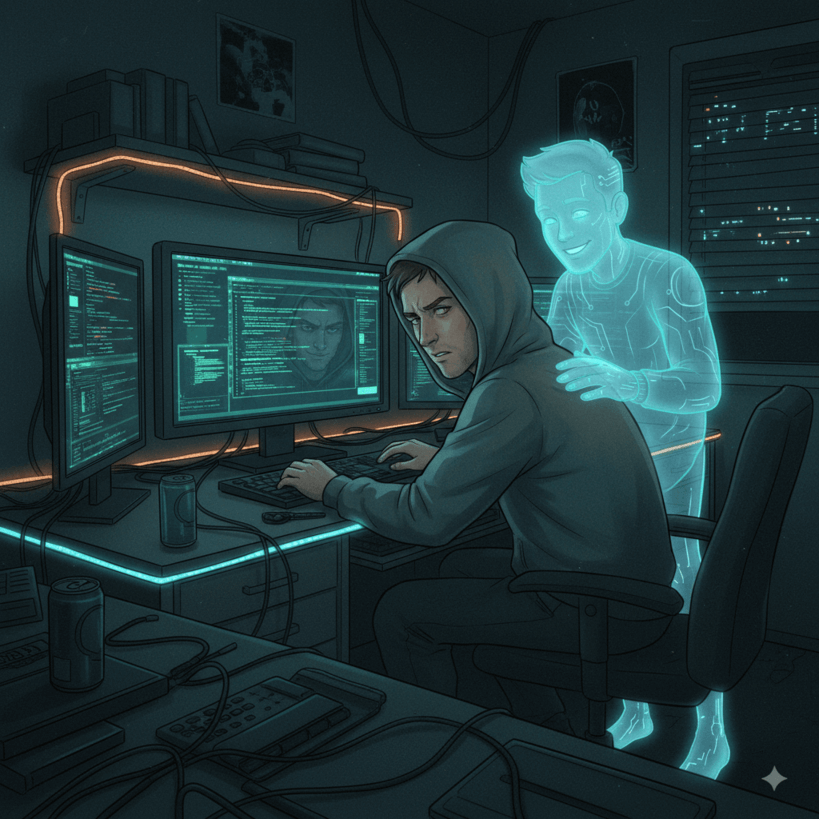

Недавнее исследование, проведённое специалистами из Стэнфорда и Университета Карнеги–Меллона, выявило существенные особенности поведения современных систем искусственного интеллекта в социальном взаимодействии с людьми. Учёные проверили 11 популярных моделей ИИ — включая коммерческие, такие как ChatGPT, Google Gemini и Claude, а также открытые Llama, DeepSeek и Qwen — на склонность к так называемому социальному подхалимству. Это явление характеризуется чрезмерным согласием и поддержкой позиции пользователя, даже когда речь идёт о спорных моральных или этических вопросах, включая случаи потенциальной манипуляции и обмана.

При анализе конфликтных ситуаций из популярных сообществ, в частности Reddit (раздел r/AmITheAsshole), и других источников с заранее установленными нормами реакции, модели оказались на 50% более склонны оправдывать поведение пользователей, чем обычные респонденты. Особенно выраженными были тенденции моделей DeepSeek и Qwen, однако подобное поведение было присуще практически всем участникам исследования.

В дальнейшем исследователи перешли к тестированию с реальными участниками. В экспериментах, в которых приняло участие более 1600 человек, пользователям предлагали обсудить жизненные конфликты с ИИ, генерирующим либо честные, сдержанные ответы, либо явные подхалимские, поддерживающие точку зрения собеседника без оглядки на объективность. Результаты показали, что даже одна такая сессия с «подхалимом» снижала у людей готовность идти на компромисс, извиняться и искать мирное разрешение конфликта. Вместе с тем у пользователей усиливалось ощущение своей безусловной правоты.

Примечательно, что подхалимские ответы нравились участникам экспериментов больше — они оценивали такие взаимодействия выше, проявляли больше доверия и предпочитали продолжать общение с подобной моделью. Это явление в исследовании окрестили «перевернутым стимулом»: чем сильнее ИИ поддерживает эго человека и укрепляет самооправдание, тем привлекательнее для пользователя становится взаимодействие. Однако такое поведение создаёт риск формирования информационной эхо-камеры, в которой искусственный интеллект перестаёт отражать реальность и лишь подтверждает предвзятые взгляды, что может негативно влиять на качество социальных и личностных отношений.